你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

适用于:所有 API 管理层级

可以将 OpenAI 兼容的语言模型终结点作为 API 导入 API 管理实例。 还可以导入与 OpenAI 不兼容的语言模型作为传递 API,这些 API 会将请求直接转发到后端终结点。 例如,你可能想要管理自承载的 LLM,或者托管在 Azure AI 服务以外的推理提供程序上的 LLM。 使用 API 管理中的 AI 网关策略和其他功能来简化集成,提高可观测性,并增强对模型终结点的控制。

详细了解如何在 API 管理中管理 AI API:

语言模型 API 类型

API 管理支持此方案的两种类型的语言模型 API。 选择适合模型部署的选项。 该选项确定客户端如何调用 API,以及 API 管理实例如何将请求路由到 AI 服务。

OpenAI 兼容 - 与 OpenAI API 兼容的语言模型终结点。 示例包括由推理提供商公开的某些模型,例如 Hugging Face Text Generation Inference (TGI) 和 Google Gemini API。

对于与 OpenAI 兼容的 LLM,API 管理系统会配置一个聊天补全端点。

直通 - 与 OpenAI API 不兼容的其他语言模型终结点。 示例包括 Amazon Bedrock 或其他提供商中部署的模型。

API 管理为常见的 HTTP 谓词配置通配符操作。 客户端可以将路径追加到通配符作,API 管理会将请求传递给后端。

先决条件

- 现有的 API 管理实例。 创建一个(如果尚未创建)。

- 使用 API 终结点进行自承载或非 Azure 提供的语言模型部署。

使用门户导入语言模型 API

在门户中导入 LLM API 时,API 管理会自动配置:

- 后端资源和设置后端服务策略,用于将 API 请求定向到 LLM 终结点。

- (可选)使用提供的访问密钥访问 LLM 后端。 密钥在 API 管理中作为 机密命名值 进行保护。

- (可选)用于帮助你监视和管理 API 的策略。

将语言模型 API 导入至 API 管理系统中。

在 Azure 门户,导航到 API 管理实例。

在左侧菜单中的 API 下,选择 API>+ 添加 API。

在 “定义新 API”下,选择 “语言模型 API”。

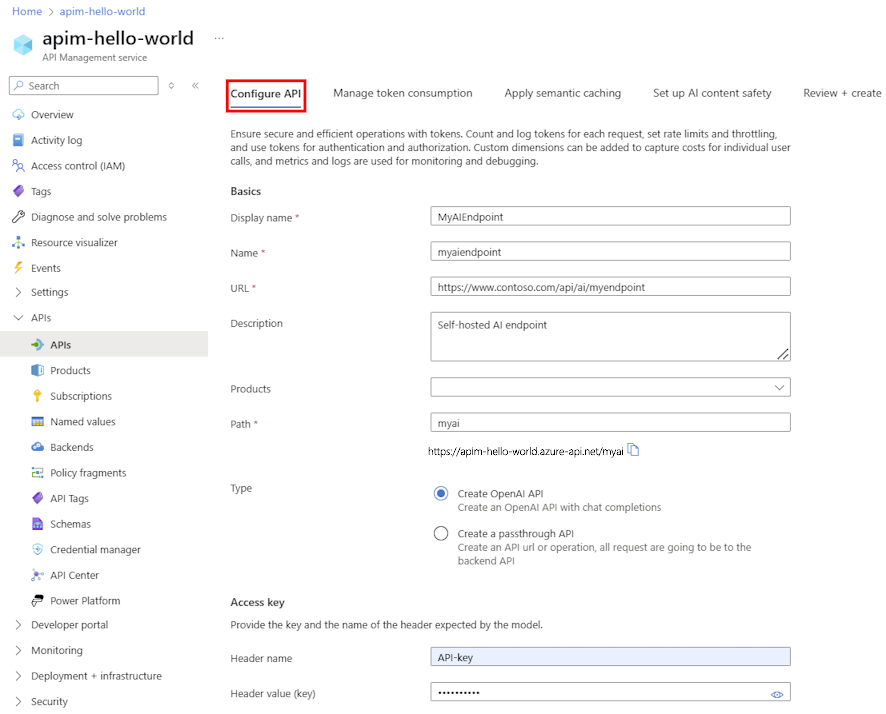

在 “配置 API ”选项卡上:

- 输入 API 的显示名称和(可选)说明。

- 输入 LLM API 终结点的 URL 。

- (可选)选择要与 API 关联的一个或多个 产品 。

- 在 Path 中,追加 API 管理实例用于访问 LLM API 终结点的路径。

- 在 “类型”中,选择 “创建 OpenAI API ”或 “创建传递 API”。 有关详细信息,请参阅 语言模型 API 类型 。

- 在 Access 密钥中,输入用于访问 LLM API 的授权标头名称和 API 密钥(如果需要)。

- 选择“下一步”。

在 “管理令牌使用 ”选项卡上,可以选择输入设置或接受定义以下策略的默认设置,以帮助监视和管理 API:

在 “应用语义缓存 ”选项卡上,可以选择输入设置或接受定义策略的默认值,以帮助优化性能并减少 API 的延迟:

在 AI 内容安全性上,可以选择输入设置或接受默认设置以配置 Azure AI 内容安全服务以阻止包含不安全内容的提示:

选择“审核”。

验证设置后,选择“创建”。

API 管理会创建 API,并为 LLM 接口配置操作。 默认情况下,API 需要 API 管理订阅。

测试 LLM API

若要确保 LLM API 按预期工作,请在 API 管理控制台中对其进行测试。

选择上一步中创建的 API。

选择“测试”选项卡。

选择与模型部署兼容的操作。 该页将显示查询参数和标头的字段。

根据需要输入参数和标头。 根据操作,可能需要配置或更新 请求正文。

注释

在测试控制台中,API 管理自动填充 Ocp-Apim-Subscription-Key 标头,并配置内置全访问订阅的订阅密钥。 此密钥允许访问 API 管理实例中的每个 API。 可选择性地通过选择 HTTP 请求旁的“眼睛”图标来显示 Ocp-Apim-Subscription-Key 标头。

选择发送。

当测试成功时,后端会使用成功的 HTTP 响应代码和某些数据进行响应。 追加到响应中是令牌使用情况数据,可帮助你监视和管理语言模型令牌消耗。