你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

适用于:所有 API 管理层级

本文介绍如何导入与 OpenAI 兼容的 Google Gemini API 以访问模型,例如 gemini-2.0-flash。 对于这些模型,Azure API 管理可以管理与 OpenAI 兼容的聊天完成终结点。

详细了解如何在 API 管理中管理 AI API:

先决条件

- 现有的 API 管理实例。 创建一个(如果尚未创建)。

- Gemini API 的 API 密钥。 如果没有,请在 Google AI Studio 中创建它并将其存储在安全的位置。

使用门户导入与 OpenAI 兼容的 Gemini API

在 Azure 门户,导航到 API 管理实例。

在左侧菜单中的 API 下,选择 API>+ 添加 API。

在 “定义新 API”下,选择 “语言模型 API”。

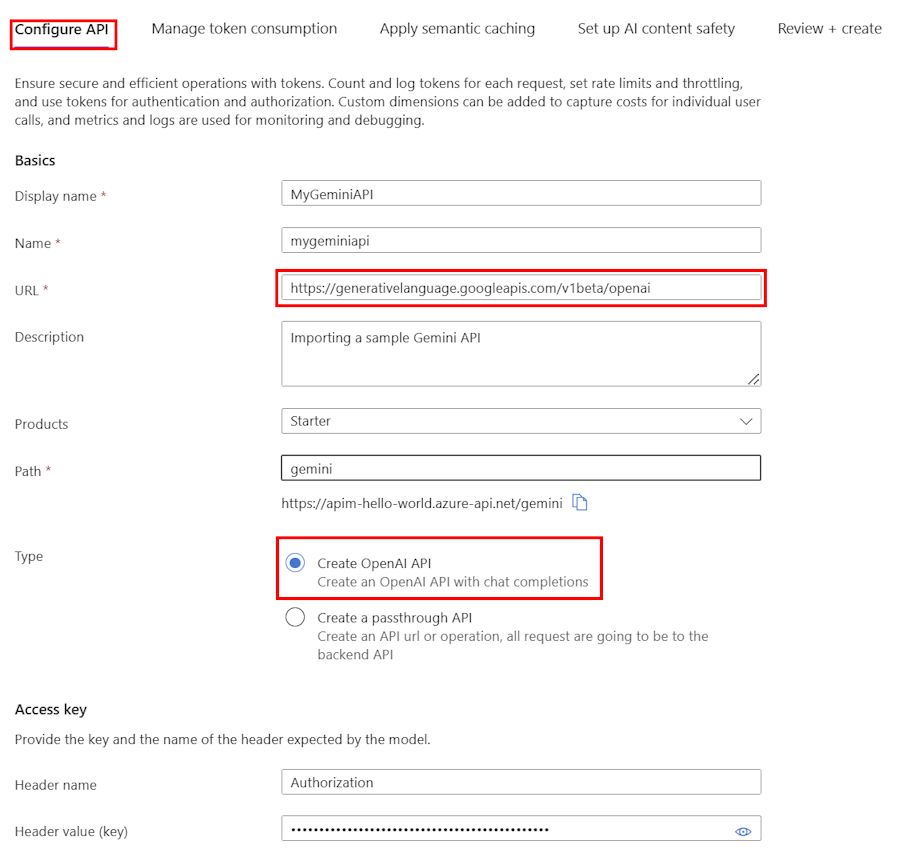

在 “配置 API ”选项卡上:

输入 API 的显示名称和(可选)说明。

在 URL 中,输入来自 Gemini OpenAI 兼容性文档的以下基础URL:

https://generativelanguage.googleapis.com/v1beta/openai在 Path 中,追加 API 管理实例用于将请求路由到 Gemini API 终结点的路径。

在 “类型”中,选择“ 创建 OpenAI API”。

在 Access 密钥中,输入以下内容:

- 标头名称: 授权。

-

请求头值(键):

Bearer紧跟在其后的是 Gemini API 的 API 密钥。

在其余选项卡上,可以选择配置策略来管理令牌消耗、语义缓存和 AI 内容安全性。 有关详细信息,请参阅 导入语言模型 API。

选择“审核”。

验证设置后,选择“创建”。

API 管理创建 API 并配置以下内容:

- 后端资源和设置后端服务策略,用于将 API 请求定向到 Google Gemini 终结点。

- 使用提供的 Gemini API 密钥访问 LLM 后端。 密钥在 API 管理中作为 机密命名值 进行保护。

- (可选)用于帮助你监视和管理 API 的策略。

测试 Gemini 模型

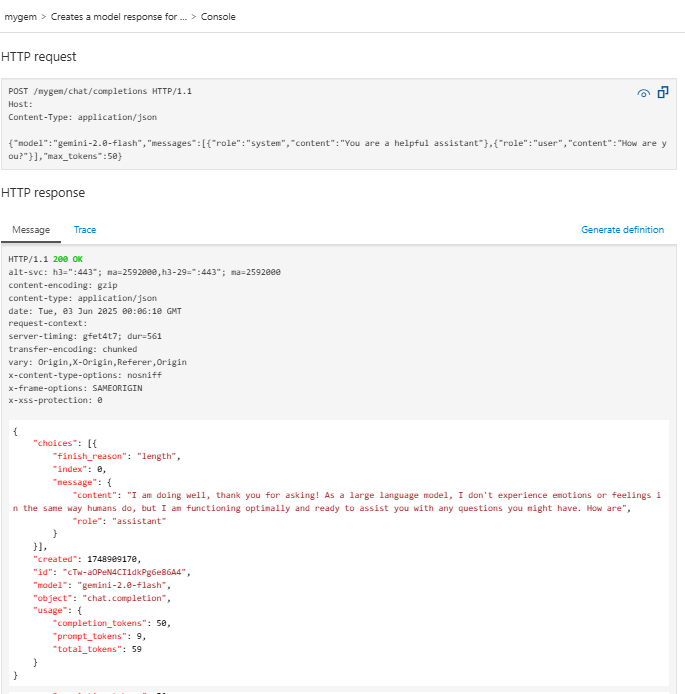

导入 API 后,可以测试 API 的聊天完成终结点。

选择在上一步中创建的 API。

选择“测试”选项卡。

选择

POST Creates a model response for the given chat conversation操作,这是向/chat/completions端点发出的POST请求。在 “请求正文 ”部分中,输入以下 JSON 以指定模型和示例提示。 在此示例中使用了

gemini-2.0-flash模型。{ "model": "gemini-2.0-flash", "messages": [ { "role": "system", "content": "You are a helpful assistant" }, { "role": "user", "content": "How are you?" } ], "max_tokens": 50 }当测试成功时,后端会使用成功的 HTTP 响应代码和某些数据进行响应。 追加到响应中是令牌使用情况数据,可帮助你监视和管理语言模型令牌消耗。