適用対象: すべての API Management レベル

OpenAI 互換言語モデル エンドポイントを API として API Management インスタンスにインポートできます。 また、バックエンド エンドポイントに直接要求を転送するパススルー API として、OpenAI と互換性のない言語モデルをインポートすることもできます。 たとえば、自己ホストする LLM、または Azure AI サービス以外の推論プロバイダーでホストされている LLM を管理できます。 API Management で AI ゲートウェイ ポリシーやその他の機能を使用して、統合を簡素化し、監視性を向上させ、モデル エンドポイントの制御を強化します。

API Management での AI API の管理の詳細については、以下を参照してください。

言語モデル API の種類

API Management では、このシナリオで 2 種類の言語モデル API がサポートされています。 モデルのデプロイに適したオプションを選択します。 このオプションは、クライアントが API を呼び出す方法と、API Management インスタンスが AI サービスに要求をルーティングする方法を決定します。

OpenAI 互換 - OpenAI の API と互換性のある言語モデル エンドポイント。 たとえば、 Hugging Face Text Generation Inference (TGI) や Google Gemini API など、推論プロバイダーによって公開される特定のモデルが挙げられます。

OpenAI と互換性のある LLM の場合、API Management はチャット完了エンドポイントを構成します。

パススルー - OpenAI の API と互換性のない他の言語モデル エンドポイント。 たとえば、 Amazon Bedrock やその他のプロバイダーにデプロイされたモデルが挙げられます。

API Management は、一般的な HTTP 動詞のワイルドカード操作を構成します。 クライアントはワイルドカード操作にパスを追加でき、API Management はバックエンドに要求を渡します。

[前提条件]

- 既存の API Management インスタンスがある。 まだない場合は、作成してください。

- API エンドポイントを使用したセルフホステッドまたは Azure 以外の言語モデルのデプロイ。

ポータルを使用して言語モデル API をインポートする

ポータルで LLM API をインポートすると、API Management によって自動的に次の構成が行われます。

- API 要求を LLM エンドポイントに送信する バックエンド リソースと セット バックエンド サービス ポリシー。

- (必要に応じて)指定したアクセス キーを使用して LLM バックエンドにアクセスします。 キーは、API Management で シークレットの名前付き値 として保護されます。

- (必要に応じて)API の監視と管理に役立つポリシー。

API Management に言語モデル API をインポートするには:

Azure portal で、API Management インスタンスに移動します。

左側のメニューの [API] で、[API]>[+ API の追加] を選択します。

[ 新しい API の定義] で、[ 言語モデル API] を選択します。

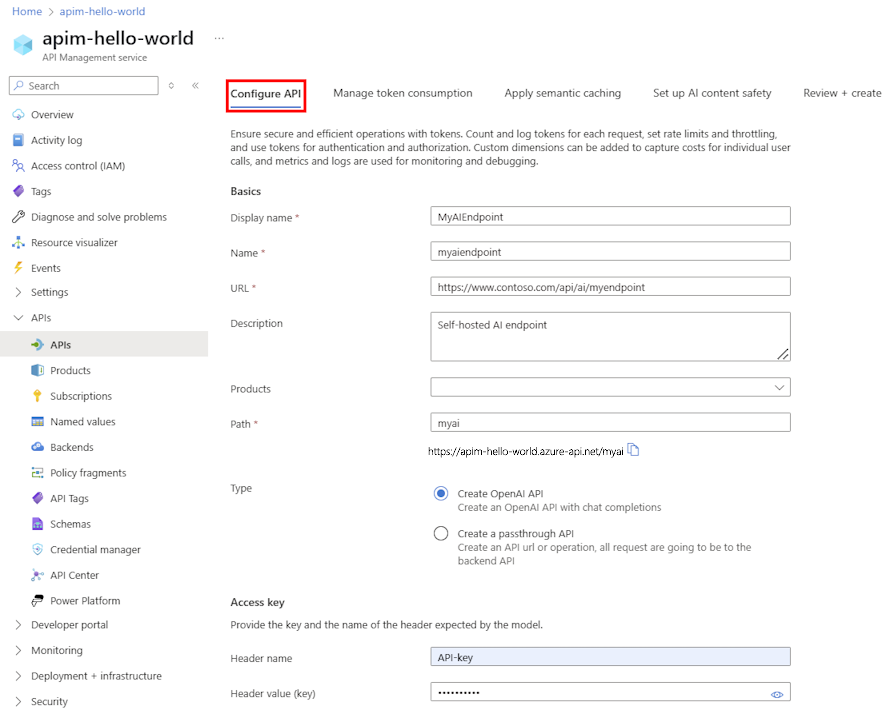

[ API の構成 ] タブで、次の手順を実行します。

- API の表示名と、必要に応じて説明を入力します。

- LLM API エンドポイントの URL を 入力します。

- 必要に応じて、API に関連付ける 1 つ以上の 製品 を選択します。

- [パス] に、API Management インスタンスが LLM API エンドポイントへのアクセスに使用するパスを追加します。

- [種類] で、[OpenAI API の作成] または [パススルー API の作成] を選択します。 詳細については、「 言語モデル API の種類 」を参照してください。

- 必要に応じて、[ アクセス キー] に、LLM API へのアクセスに使用する承認ヘッダー名と API キーを入力します。

- [次へ] を選択します。

[ トークン消費の管理 ] タブで、必要に応じて設定を入力するか、API の監視と管理に役立つ次のポリシーを定義する既定値を受け入れます。

[ セマンティック キャッシュの適用 ] タブで、必要に応じて設定を入力するか、API のパフォーマンスの最適化と待機時間の短縮に役立つポリシーを定義する既定値を受け入れます。

AI コンテンツ の安全性で、必要に応じて設定を入力するか、既定値を受け入れて、安全でないコンテンツを含むプロンプトをブロックするように Azure AI Content Safety サービスを構成します。

[レビュー] を選択します。

設定が検証されたら、[作成] を選択します。

API Management によって API が作成され、LLM エンドポイントの操作が構成されます。 既定では、API には API Management サブスクリプションが必要です。

LLM API をテストする

LLM API が期待どおりに動作していることを確認するには、API Management テスト コンソールでテストします。

前の手順で作成した API を選びます。

[テスト] タブを選びます。

モデルのデプロイと互換性のある操作を選択します。 ページにパラメーターとヘッダーのフィールドが表示されます。

必要に応じてパラメーターとヘッダーを入力します。 操作によっては、 要求本文の構成または更新が必要になる場合があります。

注

テスト コンソールでは、API Management によって Ocp-Apim-Subscription-Key ヘッダーが自動的に設定され、組み込みの オール アクセス サブスクリプションのサブスクリプション キーが構成されます。 このキーを使用すると、API Management インスタンス内のすべての API にアクセスできます。 必要に応じて、 HTTP 要求の横にある "目" のアイコンを選択して、 Ocp-Apim-Subscription-Key ヘッダーを表示します。

[Send] を選択します。

テストが成功すると、バックエンドは成功した HTTP 応答コードと一部のデータで応答します。 応答に追加されるのは、言語モデルのトークン消費を監視および管理するのに役立つトークン使用状況データです。