適用対象: すべての API Management レベル

この記事では、OpenAI と互換性のある Google Gemini API をインポートして、 gemini-2.0-flashなどのモデルにアクセスする方法について説明します。 これらのモデルでは、Azure API Management で OpenAI と互換性のあるチャット入力候補エンドポイントを管理できます。

API Management での AI API の管理の詳細については、以下を参照してください。

[前提条件]

- 既存の API Management インスタンスがある。 まだない場合は、作成してください。

- Gemini API の API キー。 お持ちでない場合は、 Google AI Studio で作成し、安全な場所に保存してください。

ポータルを使用して OpenAI と互換性のある Gemini API をインポートする

Azure portal で、API Management インスタンスに移動します。

左側のメニューの [API] で、[API]>[+ API の追加] を選択します。

[ 新しい API の定義] で、[ 言語モデル API] を選択します。

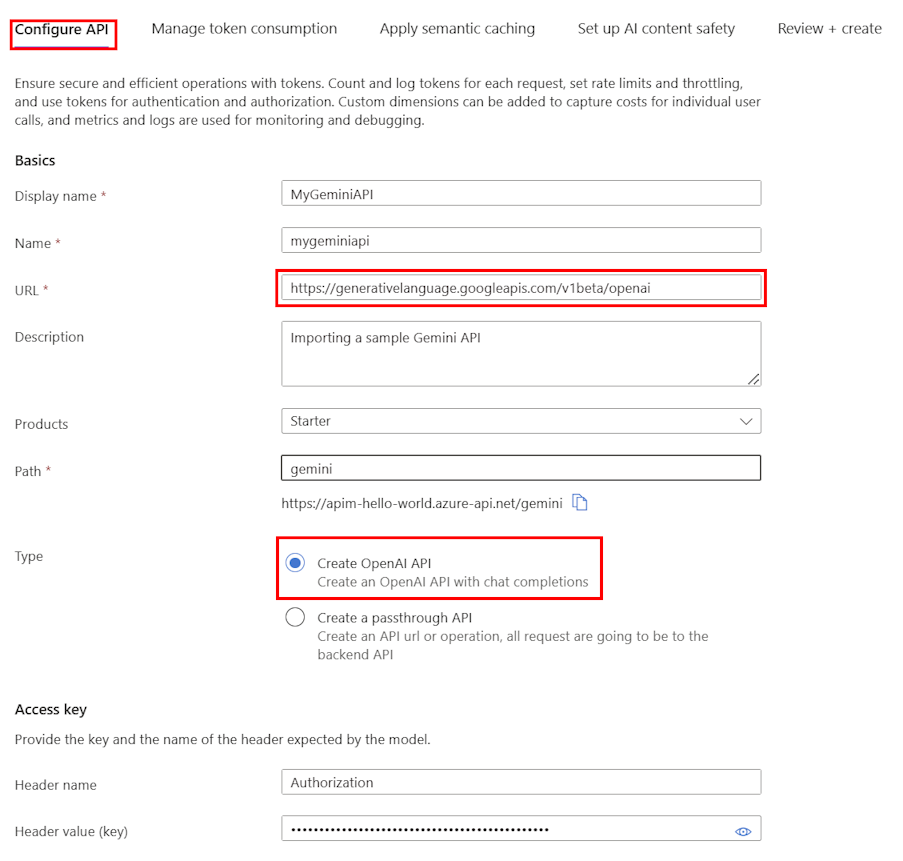

[ API の構成 ] タブで、次の手順を実行します。

API の表示名と、必要に応じて説明を入力します。

URL に、Gemini OpenAI 互換性ドキュメントから次のベース URL を入力します。

https://generativelanguage.googleapis.com/v1beta/openai[パス] で、要求を Gemini API エンドポイントにルーティングするために API Management インスタンスが使用するパスを追加します。

[種類] で、[OpenAI API の作成] を選択します。

アクセス キーで、次のように入力します。

- ヘッダー名: Authorization。

-

ヘッダー値 (キー):

Bearer後に Gemini API の API キーが続きます。

残りのタブで、必要に応じて、トークンの使用、セマンティック キャッシュ、AI コンテンツの安全性を管理するポリシーを構成します。 詳細については、「 言語モデル API のインポート」を参照してください。

[レビュー] を選択します。

設定が検証されたら、[作成] を選択します。

API Management によって API が作成され、次の構成が行われます。

- API 要求を Google Gemini エンドポイントに送信する バックエンド リソースと セット バックエンド サービス ポリシー。

- 指定した Gemini API キーを使用して LLM バックエンドにアクセスします。 キーは、API Management で シークレットの名前付き値 として保護されます。

- (必要に応じて)API の監視と管理に役立つポリシー。

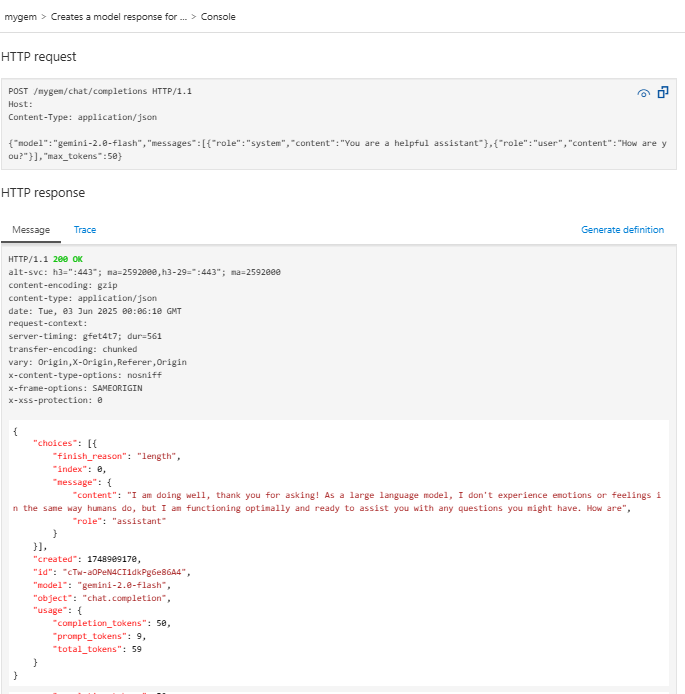

Gemini モデルをテストする

API をインポートした後、API のチャット完了エンドポイントをテストできます。

前の手順で作成した API を選択します。

[テスト] タブを選びます。

POST Creates a model response for the given chat conversation操作を選択します。これはPOST要求であり、/chat/completionsエンドポイントに送信されます。[ 要求本文 ] セクションで、次の JSON を入力してモデルとプロンプトの例を指定します。 この例では、

gemini-2.0-flashモデルが使用されます。{ "model": "gemini-2.0-flash", "messages": [ { "role": "system", "content": "You are a helpful assistant" }, { "role": "user", "content": "How are you?" } ], "max_tokens": 50 }テストが成功すると、バックエンドは成功した HTTP 応答コードと一部のデータで応答します。 応答に追加されるのは、言語モデルのトークン消費を監視および管理するのに役立つトークン使用状況データです。