在本文中,你将了解可用于编写基础模型的查询请求的选项,以及如何将它们发送到模型服务终结点。 可以查询 Databricks 托管的基础模型和 Databricks 外部托管的基础模型。

有关传统的 ML 或 Python 模型查询请求,请参阅查询自定义模型的服务终结点。

马赛克 AI 模型服务 支持 基础模型 API,外部模型 用于访问基础模型。 模型服务使用与 OpenAI 兼容的统一 API 和 SDK 进行查询。 这样,就可以跨受支持的云和提供商试验和自定义生产的基础模型。

查询选项

马赛克 AI 模型服务提供以下选项,用于向为基础模型提供服务的终结点发送查询请求:

| 方法 | 详细信息 |

|---|---|

| OpenAI 客户端 | 使用 OpenAI 客户端查询 Mosaic AI 模型服务终结点托管的模型。 将提供终结点名称的模型指定为 model 输入。 支持由基础模型 API 或外部模型提供的聊天、嵌入和完成模型。 |

| SQL 函数 | 使用 ai_query SQL 函数直接从 SQL 调用模型推理。 请参阅 示例:查询基础模型。 |

| 服务 UI | 在“服务终结点”页面中,选择“查询终结点”。 插入 JSON 格式的模型输入数据,然后单击“发送请求”。 如果模型记录了输入示例,请使用“显示示例”来加载该示例。 |

| REST API | 使用 REST API 调用和查询模型。 有关详细信息,请参阅 POST /serving-endpoints/{name}/invocations。 有关为多个模型提供服务的终结点的评分请求,请参阅查询终结点背后的单个模型。 |

| MLflow 部署 SDK | 使用 MLflow 部署 SDK 的 predict() 函数查询模型。 |

| Databricks Python SDK | Databricks Python SDK 是 REST API 上的一个层。 它处理低级别详细信息,例如身份验证,从而更轻松地与模型交互。 |

要求

- 模型服务终结点。

- Databricks 工作区位于受支持的区域中。

- 若要通过 OpenAI 客户端 REST API 或 MLflow 部署 SDK 发送评分请求,你必须有 Databricks API 令牌。

重要

作为适用于生产场景的安全最佳做法,Databricks 建议在生产期间使用计算机到计算机 OAuth 令牌来进行身份验证。

对于测试和开发,Databricks 建议使用属于服务主体(而不是工作区用户)的个人访问令牌。 若要为服务主体创建令牌,请参阅管理服务主体的令牌。

安装软件包

选择查询方法后,必须先将相应的包安装到群集。

OpenAI 客户端

若要使用 OpenAI 客户端,需要在群集上安装 databricks-sdk[openai] 包。 Databricks SDK 提供了一个包装器,用于构造 OpenAI 客户端,该客户端的授权会自动配置为查询生成 AI 模型。 在笔记本或本地终端中运行以下命令:

!pip install databricks-sdk[openai]>=0.35.0

仅当在 Databricks Notebook 上安装包时,才需要满足以下条件

dbutils.library.restartPython()

REST API

Databricks Runtime 中提供对服务 REST API 的访问,供机器学习使用。

MLflow 部署 SDK

!pip install mlflow

仅当在 Databricks Notebook 上安装包时,才需要满足以下条件

dbutils.library.restartPython()

Databricks Python SDK

所有使用 Databricks Runtime 13.3 LTS 或更高版本的 Azure Databricks 群集上均已安装了 Databricks SDK for Python。 对于使用 Databricks Runtime 12.2 LTS 及更低版本的 Azure Databricks 群集,必须先安装 Databricks SDK for Python。 请参阅 用于 Python 的 Databricks SDK。

基础模型类型

下表总结了基于任务类型支持的基础模型。

| 任务类型 | DESCRIPTION | 支持的模型 | 何时使用? 推荐用例 |

|---|---|---|---|

| 聊天 | 旨在理解和参与自然、多回合对话的模型。 它们针对大型人类对话数据集进行了微调,使它们能够生成上下文相关的响应,跟踪对话历史记录,并跨各种主题提供一致的类似人类的交互。 | 以下是支持的 Databricks 托管的基础模型:

支持以下外部模型:

|

推荐用于需要自然、多轮次交流和上下文理解的情景:

|

| 嵌入 | 嵌入模型是机器学习系统,可将复杂数据(如文本、图像或音频)转换为称为嵌入的紧凑数字向量。 这些向量捕获数据中的基本特征和关系,从而实现高效的比较、聚类分析和语义搜索。 | 以下是支持的 Databricks 托管的基础模型: 支持以下外部模型:

|

建议在需要语义理解、相似性比较以及复杂数据的高效检索和聚类的应用中使用:

|

| 愿景 | 设计用于处理、解释和分析视觉数据的模型,例如图像和视频,使计算机能够“查看”和了解视觉世界。 | 以下是支持的 Databricks 托管的基础模型: 支持以下外部模型:

|

建议在需要自动、准确和可扩展的视觉信息分析的场景中使用。

|

| 推理 | 旨在模拟类似人类逻辑思维的高级 AI 系统。 推理模型集成了符号逻辑、概率推理和神经网络等技术,用于分析上下文、分解任务并解释其决策。 | 以下是支持的 Databricks 托管的基础模型:

支持以下外部模型:

|

建议在需要自动、准确和可扩展的视觉信息分析的场景中使用。

|

函数调用

Databricks 函数调用与 OpenAI 兼容,仅在模型服务期间作为基础模型 API 的一部分提供,并提供为外部模型提供服务的终结点。 有关详细信息,请参阅 Azure Databricks 上的函数调用。

结构化输出

结构化输出与 OpenAI 兼容,仅在作为 基础模型 API 的一部分的模型服务期间可用。 有关详细信息,请参阅 Azure Databricks 上的结构化输出。

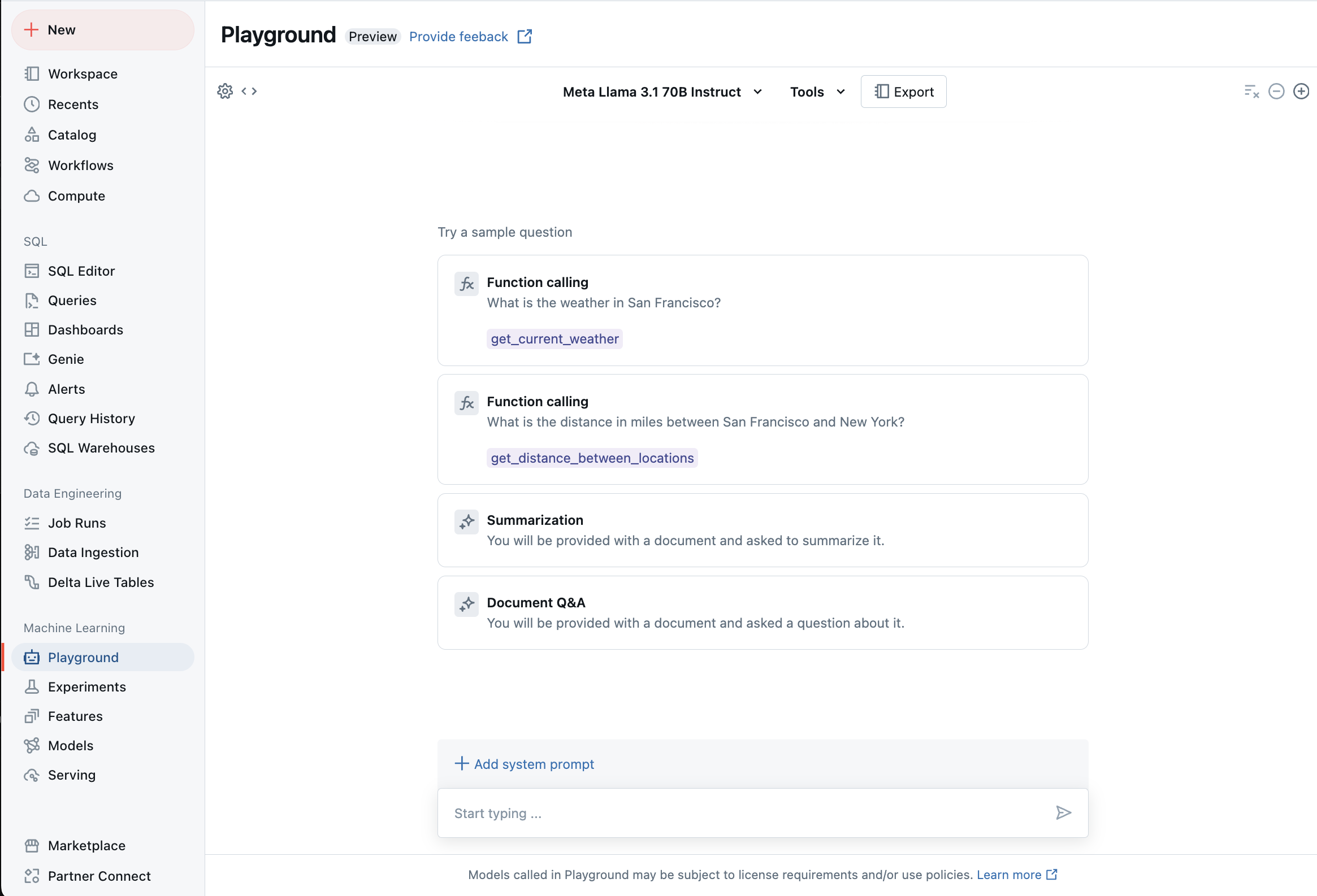

使用 AI 操场与支持的 LLM 聊天

可以使用 AI 操场与受支持的大语言模型进行交互。 AI 操场是类似聊天的环境,可以在该处测试、提示和比较 Azure Databricks 工作区的 LLM。